介绍(由于近期准备校招,博客暂时不更新)

神经风格迁移是我研一研二时期主要的研究方向,而从最初的风格迁移出现已经有较长一段时间了。之所以现在写这个博客,第一是因为我的毕业论文定的方向是风格迁移+情感分析;第二是借这篇博客以及之后的学习,能对深度学习更进一步的理解!

目录

什么是风格迁移?

-

- α 图定义为

style image, p 图定义为content image,

- α 图定义为

-

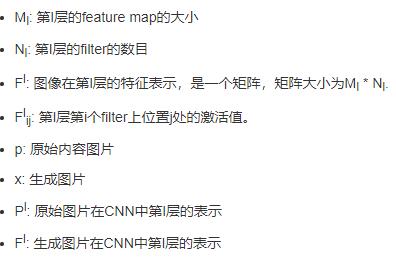

- 损失通过VGG-16的前四层来表示,层次越高,内容越抽象。这里列出几个符号定义。

-

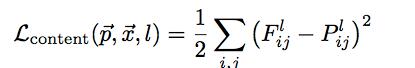

- 将内容图像输入卷积网络中提取图像内容,由公式

,计算内容损失。

,计算内容损失。

-

- 对以上公式求导

,使用反向传输,使得生成图像在

,使用反向传输,使得生成图像在内容上接近原输入内容图像。

-

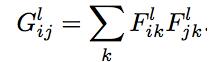

- 将风格图像输入到同一个网络中提取它的风格信息,风格提取的符号定义为

-

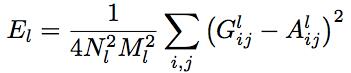

- 计算风格图像的loss

单独某层的损失函数

各层综合的损失函数

求偏导

,使得生成图像在

,使得生成图像在风格上接近原输入风格图像。

- 7.风格损失

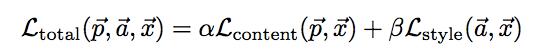

- 8.

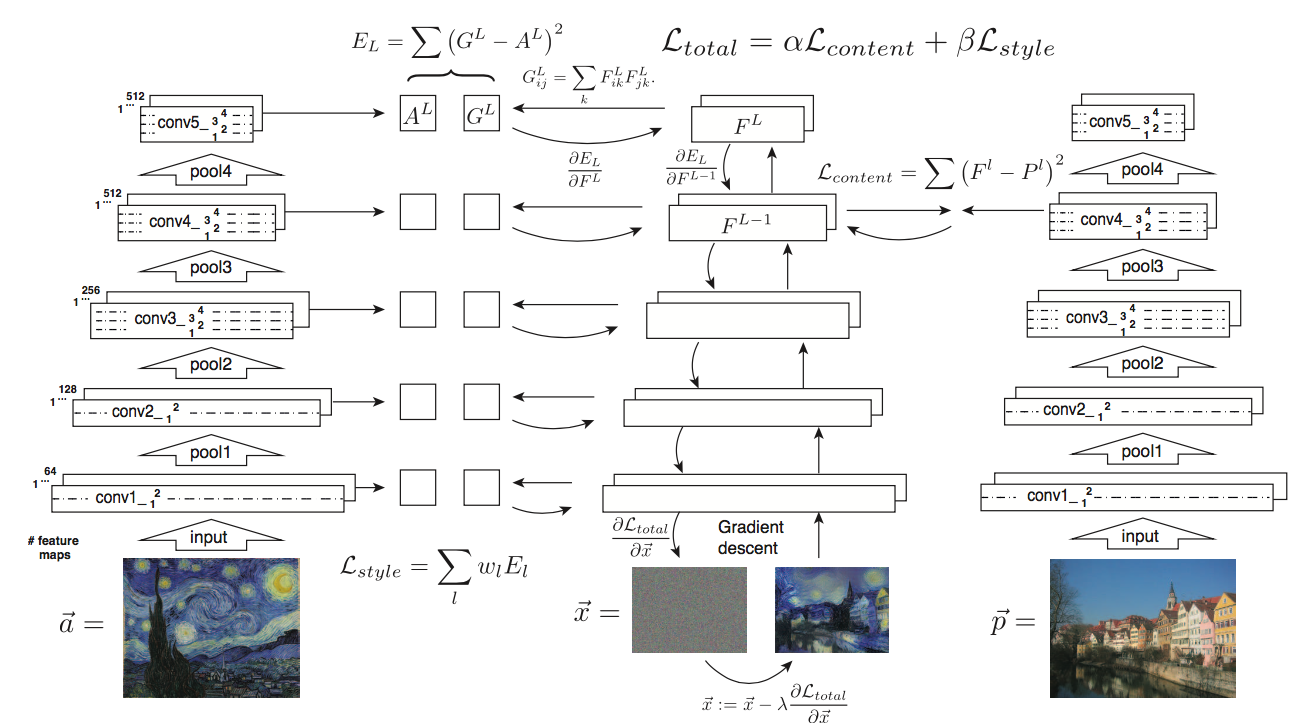

Gatys-Image-Style-Transfer中给出的流程图。X是白噪声图像。同时将三张图片输入到同一网络中,对内容图像和风格图像求特征,对白噪声X求导。

当前不同框架下的风格迁移

几年前,Gatys等人的风格迁移[paper],[code]在学术界引起了不错的反响,并催生了后续很多研究成果。虽然在Gatys之前已经有学者做迁移方面的研究,但我把这篇paper看作是first style transfer paper。

1.基于图像优化的Slow Transfer

- [A Neural Algorithm of Artistic Style ][paper]

- [Image Style Transfer Using Convolutional Neural Networks] [Paper] (CVPR 2016)

-

[Demystifying Neural Style Transfer][paper](Theoretical Explanation) (IJCAI 2017)

-

[Stable and Controllable Neural Texture Synthesis and Style Transfer Using Histogram Losses][paper]

- [Combining Markov Random Fields and Convolutional Neural Networks for Image Synthesis][paper](CVPR 2016)

2.基于模型优化的Fast Transfer

2.1Per-Style-Per-Model-Methods

- [Perceptual Losses for Real-Time Style Transfer and Super-Resolution][paper] (ECCV 2016)

- [Precomputed Real-Time Texture Synthesis with Markovian Generative Adversarial Networks] [Paper] (ECCV 2016)

-

[Texture Networks: Feed-forward Synthesis of Textures and Stylized Images] [Paper] (ICML 2016)

- [Improved Texture Networks: Maximizing Quality and Diversity in Feed-forward Stylization and Texture Synthesis] [Paper] (CVPR 2017)

- [Precomputed Real-Time Texture Synthesis with Markovian Generative Adversarial Networks] [Paper] (ECCV 2016)

- Torch-based

2.2Multiple-Style-Per-Model-Methods

-

[A Learned Representation for Artistic Style] [Paper] (ICLR 2017)

-

[Multi-style Generative Network for Real-time Transfer] [Paper]

-

[StyleBank: An Explicit Representation for Neural Image Style Transfer] [Paper] (CVPR 2017)

-

[Diversified Texture Synthesis With Feed-Forward Networks] [Paper] (CVPR 2017)

2.3Arbitrary-Style-Per-Model-Methods

- [Fast Patch-based Style Transfer of Arbitrary Style] [Paper]

-

[Arbitrary Style Transfer in Real-time with Adaptive Instance Normalization] [Paper] (ICCV 2017)